Ma_Recherche

L’avenir des IHM : surface tactile ou analyse vidéo ?

19/10/11

Chez Microsoft Research, on travail sur différentes thématiques liés au interfaces humains machines. Je vous avais parlé il y a quelques mois dans ce billet de l’usage de la peau comme surface d’interaction, en ce début d’automne, ce sont deux nouveaux projets dévoilés par le centre de recherche de la firme de Redmond : OmniTouch et PocketTouch Les deux projet prennent en compte la notion de mobilité.

Le premier projet est basé sur la vision par ordinateur (computer vision) consiste à utiliser un vidéoprojecteur affichant une image qui est analysée par un capteur qui détecte les mouvements de l’utilisateur. C’est une interprétation du projet 6th Sens en utilisant le savoir faire de la Kinect pour obtenir une information de profondeur et savoir si le doigt touche ou non la surface d’affichage.

Le premier projet est basé sur la vision par ordinateur (computer vision) consiste à utiliser un vidéoprojecteur affichant une image qui est analysée par un capteur qui détecte les mouvements de l’utilisateur. C’est une interprétation du projet 6th Sens en utilisant le savoir faire de la Kinect pour obtenir une information de profondeur et savoir si le doigt touche ou non la surface d’affichage.

Le second projet Utilise un capteur tactile capacitif pour détecter des gestuelles à travers un textile. Le principe étant de piloter des fonctionnalités d’un mobile alors que celui ci est dans sa poche.

La calibration est différente selon le type de tissus utilisés, mais l’application pourrait donner des pistes intéressantes.

Plus d’infos sur le site de Chris Harrison (également à l’origine du projet SkinPut)

• OmniTouch

• PocketTouch

Retour d’effort sur écran tactile : de la vibration au tixel

20/07/11

свети атанасUn utilisateur de tablette, smartphone ou autre terminal mobile à écran tactile a besoin de savoir si sa machine a bien comprit qu’il vient d’appuyer sur un bouton virtuel affiché à l’écran. Les concepteurs d’interfaces utilisent principalement deux méthodes (cumulables) pour donner ce retour d’information (feedback) :

• Le retour d’effort : en faisant vibrer tout le terminal pour symboliser la pression d’une partie de l’écran. C’est facile à mettre en œuvre, ça marche assez bien. Mais c’est limité à une pression à la fois (pas de multitouch) et c’est un retour très binaire (qu’on effleure ou qu’on frappe son écran, seule la durée de vibration peut varier, pas vraiment son intensité. )

• La substitution sensorielle : en utilisant l’ouïe ou la vision de l’utilisateur à la place de retour tactile on peut arriver à tes effets plus localisés. On utilise alors des sons, ou des effets visuels pour indiquer que la touche est « pressée ».

• La substitution sensorielle : en utilisant l’ouïe ou la vision de l’utilisateur à la place de retour tactile on peut arriver à tes effets plus localisés. On utilise alors des sons, ou des effets visuels pour indiquer que la touche est « pressée ».

Pour le son, on utilise essentiellement des « clics » qui rappellent l’usage d’un bon vieux clavier ou d’une souris

Pour le visuels, les effets courant sont

- l’illumination : un halo lumineux indique l’activation de la touche.

- l’ombrages : pour pousser la métaphore de l’enfoncement.

- la délocalisation de la touche (mini pop up) qui permet d’afficher la touche pressée alors qu’elle est occultée par le doigt de l’utilisateur (pour une fois un sort de la métaphore pour entrer dans l’idiomatique http://www.multimedialab.be/doc/alan_cooper.htm)

La société Finlandaise Senseg a mis au point un dispositif de retour tactile qui ne génère pas de vibrations mécaniques et qui peut se coupler à une interface multitouch + écran.

La société Finlandaise Senseg a mis au point un dispositif de retour tactile qui ne génère pas de vibrations mécaniques et qui peut se coupler à une interface multitouch + écran.

L’avantage de se passer des vibrations mécanique, c’est de pouvoir localiser l’effet (on ne fait plus vibrer la totalité de l’appareil) et d’éviter la perturbation sonore crée par un moteur.

Le dispositif utilise des minuscules céllules nommées tixel (pour « tactile pixels ») qui génères des champs électriques. L’intensité de chaque tixel est contrôlable, ainsi à l’instar des pixels qui génèrent une image, les tixel génèrent une texture dynamique que l’on ressent passant le doigt sur la surface.

Quand on examine de plus près la description que fait Senseg de son produit on peut lire que les champs magnétiques « s’étendent sur plusieurs millimètres au-dessus de surface de l’appareil ». Ce qui offre la possibilité de donner des sensations tactiles lors du survol d’une zone.

Couplez cette technologie avec une détection de la présence du doigt avant le contact avec la surface de l’écran ( cf brevet Apple cité dans ce billet ), et vous obtiendrez la prochaine grande évolution des interfaces tactile multitouch.

Couplez cette technologie avec une détection de la présence du doigt avant le contact avec la surface de l’écran ( cf brevet Apple cité dans ce billet ), et vous obtiendrez la prochaine grande évolution des interfaces tactile multitouch.

Si vous passez à Helsinki ou Tokyo, vous pouvez contacter Senseg pour tester le dispositif.

Source : springwise

Utiliser la peau comme interface d’interaction

10/03/11

Le projet “Skinput” dévoilé par Microsoft Research vise à faire de notre bras une véritable télécommande numérique. Le principe est simple : quand on le tapote son avant-bras avec un doigt, il subit une mini onde de choc qui se propage le long du bras.

L’équipe du Human Computer Interaction Institute a développé un bracelet qui s’enfile comme un tensiomètre et capte ces ondes de choc. En analysant les réactions aux tapotements sur la peau, il est possible d’utiliser le bras comme interface d’entrée pour le contrôle de machines. Coupler cette interface naturelle avec un (pico)projecteur permet de transformer sa peau en écran tactile.

La miniaturisation de l’électronique pourra trouver un fort intérêt à limiter la taille des interfaces d’entrée et utiliser des surfaces existante comme “input”, une table, un mur… c’est d’ailleur l’objet de cet autre projet de la recherche Microsoft : Light Space

Keep in touch (ou l’avenir du tactile)

10/02/11

Il y a quelques années que je vous parlais ici même de l’émergence de projets de recherche utilisant le doigt sur une surface plane comme interface homme machine. Des travaux tactiles de Jeff Han (Multi-Touch Interaction dont je vous parlais ici) à ceux sans contact de Andy Wilson (Touch Light, présenté à Laval Virtual en 2006) en passant par le prototype Tactapad (dont je vous parlais ici).

Toutes ces réflexions ont porté leurs fruits, des produits grand public, Apple et Microsoft on choisit des échèles différentes, la version de poche pour l’iPhone, la version mobilier pour table tactile (et tangible) Surface. Deux bons exemples des usages actuels : Le tactile localisé. C’est-à-dire que l’on touche l’écran pour interagir (comme les travaux de Jeff Han cités ci-dessus). C’est un concept ergonomique très simple pour nos petits cerveaux, mais qui pose un problème pour le généraliser à un ordinateur personnel : nos doigts masquent la partie de l’écran que l’on touche.

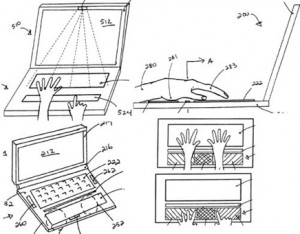

Pour des travaux de précisions, cela devient vite un frein (j’imagine difficilement travailler sur le d’illustration vectorielle sur un détourage photo ou sur un tableur chargé de mini-cellules sans un pointeur ultra-précis. La plus grosse évolution à attendre pour le tactile localisé est la détection de la présence du doigt avant le contact avec la surface (comme les travaux d’Andy Wilson cités ci-dessus). Cette évolution arrivera dans les 2 ans à venir d’après moi, Apple est déjà sur le coup avec le dépôt de son brevet # 20110007021.

Pour conclure sur ce point, en terme d’ergonomie, ce type d’interface est adapté aux périphériques mobiles (que l’on a en main ou sur ses genoux) , pas à un écran vertical (trop de fatigue musculaire en cas d’utilisation longue).

L’avenir de ce type d’IHM pour nos bons vieux postes de travail est donc ailleurs, à mon avis sur le tactile déporté : c’est-à-dire que la surface que l’on touche, caresse et tapote n’est pas l’écran. Actuellement c’est nos bons vieux trackpads qui se chargent de ça. Intégrés aux ordinateurs portables, ils colonisent maintenant nos postes de travail avec des versions de bureau. On voit même émerger des produits hybrides regroupant des fonctions de tablette graphique et trackpad (comme la gamme Bamboo Touch chez Wacom).

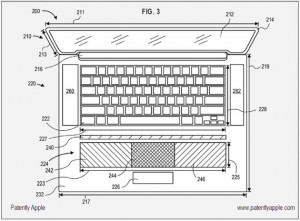

Alors, me direz-vous, si cela existe, en quoi est-ce le futur ? Et bien, vous répondrai-je, parce que la limite actuelle est que ces dispositifs permettent de contrôler un unique pointeur, on est loin du multitouch. Donc, soyons précis, l’avenir est le tactile déporté multitouch (comme le Tactapad cité ci-dessus). Et là c’est la course à l’innovation, de nouveau Apple est en course avec du dépôt de brevet dans ce domaine. L’élargissement du trackpad sur les portables est une piste sérieuse, ça laisse la place pour 2 mains. (Voir le brevet )

Qui dit nouvelle interface d’entrée (sous les doigts) dit nouvelle interface graphique (sur l’écran) pour cela les travaux du designer Robert Clayton Miller de l’agence de conception Web Tonic Blue [publication en 2009] apportent de bonnes idées. Je vous laisse découvrir cette vidéo très bien faite :