Article tagué IHM

Retour d’effort sur écran tactile : de la vibration au tixel

20/07/11

свети атанасUn utilisateur de tablette, smartphone ou autre terminal mobile à écran tactile a besoin de savoir si sa machine a bien comprit qu’il vient d’appuyer sur un bouton virtuel affiché à l’écran. Les concepteurs d’interfaces utilisent principalement deux méthodes (cumulables) pour donner ce retour d’information (feedback) :

• Le retour d’effort : en faisant vibrer tout le terminal pour symboliser la pression d’une partie de l’écran. C’est facile à mettre en œuvre, ça marche assez bien. Mais c’est limité à une pression à la fois (pas de multitouch) et c’est un retour très binaire (qu’on effleure ou qu’on frappe son écran, seule la durée de vibration peut varier, pas vraiment son intensité. )

• La substitution sensorielle : en utilisant l’ouïe ou la vision de l’utilisateur à la place de retour tactile on peut arriver à tes effets plus localisés. On utilise alors des sons, ou des effets visuels pour indiquer que la touche est « pressée ».

• La substitution sensorielle : en utilisant l’ouïe ou la vision de l’utilisateur à la place de retour tactile on peut arriver à tes effets plus localisés. On utilise alors des sons, ou des effets visuels pour indiquer que la touche est « pressée ».

Pour le son, on utilise essentiellement des « clics » qui rappellent l’usage d’un bon vieux clavier ou d’une souris

Pour le visuels, les effets courant sont

- l’illumination : un halo lumineux indique l’activation de la touche.

- l’ombrages : pour pousser la métaphore de l’enfoncement.

- la délocalisation de la touche (mini pop up) qui permet d’afficher la touche pressée alors qu’elle est occultée par le doigt de l’utilisateur (pour une fois un sort de la métaphore pour entrer dans l’idiomatique http://www.multimedialab.be/doc/alan_cooper.htm)

La société Finlandaise Senseg a mis au point un dispositif de retour tactile qui ne génère pas de vibrations mécaniques et qui peut se coupler à une interface multitouch + écran.

La société Finlandaise Senseg a mis au point un dispositif de retour tactile qui ne génère pas de vibrations mécaniques et qui peut se coupler à une interface multitouch + écran.

L’avantage de se passer des vibrations mécanique, c’est de pouvoir localiser l’effet (on ne fait plus vibrer la totalité de l’appareil) et d’éviter la perturbation sonore crée par un moteur.

Le dispositif utilise des minuscules céllules nommées tixel (pour « tactile pixels ») qui génères des champs électriques. L’intensité de chaque tixel est contrôlable, ainsi à l’instar des pixels qui génèrent une image, les tixel génèrent une texture dynamique que l’on ressent passant le doigt sur la surface.

Quand on examine de plus près la description que fait Senseg de son produit on peut lire que les champs magnétiques « s’étendent sur plusieurs millimètres au-dessus de surface de l’appareil ». Ce qui offre la possibilité de donner des sensations tactiles lors du survol d’une zone.

Couplez cette technologie avec une détection de la présence du doigt avant le contact avec la surface de l’écran ( cf brevet Apple cité dans ce billet ), et vous obtiendrez la prochaine grande évolution des interfaces tactile multitouch.

Couplez cette technologie avec une détection de la présence du doigt avant le contact avec la surface de l’écran ( cf brevet Apple cité dans ce billet ), et vous obtiendrez la prochaine grande évolution des interfaces tactile multitouch.

Si vous passez à Helsinki ou Tokyo, vous pouvez contacter Senseg pour tester le dispositif.

Source : springwise

Utiliser la peau comme interface d’interaction

10/03/11

Le projet “Skinput” dévoilé par Microsoft Research vise à faire de notre bras une véritable télécommande numérique. Le principe est simple : quand on le tapote son avant-bras avec un doigt, il subit une mini onde de choc qui se propage le long du bras.

L’équipe du Human Computer Interaction Institute a développé un bracelet qui s’enfile comme un tensiomètre et capte ces ondes de choc. En analysant les réactions aux tapotements sur la peau, il est possible d’utiliser le bras comme interface d’entrée pour le contrôle de machines. Coupler cette interface naturelle avec un (pico)projecteur permet de transformer sa peau en écran tactile.

La miniaturisation de l’électronique pourra trouver un fort intérêt à limiter la taille des interfaces d’entrée et utiliser des surfaces existante comme “input”, une table, un mur… c’est d’ailleur l’objet de cet autre projet de la recherche Microsoft : Light Space

Keep in touch (ou l’avenir du tactile)

10/02/11

Il y a quelques années que je vous parlais ici même de l’émergence de projets de recherche utilisant le doigt sur une surface plane comme interface homme machine. Des travaux tactiles de Jeff Han (Multi-Touch Interaction dont je vous parlais ici) à ceux sans contact de Andy Wilson (Touch Light, présenté à Laval Virtual en 2006) en passant par le prototype Tactapad (dont je vous parlais ici).

Toutes ces réflexions ont porté leurs fruits, des produits grand public, Apple et Microsoft on choisit des échèles différentes, la version de poche pour l’iPhone, la version mobilier pour table tactile (et tangible) Surface. Deux bons exemples des usages actuels : Le tactile localisé. C’est-à-dire que l’on touche l’écran pour interagir (comme les travaux de Jeff Han cités ci-dessus). C’est un concept ergonomique très simple pour nos petits cerveaux, mais qui pose un problème pour le généraliser à un ordinateur personnel : nos doigts masquent la partie de l’écran que l’on touche.

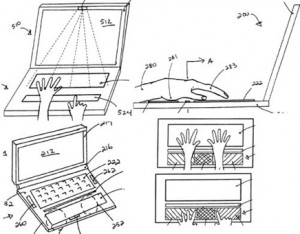

Pour des travaux de précisions, cela devient vite un frein (j’imagine difficilement travailler sur le d’illustration vectorielle sur un détourage photo ou sur un tableur chargé de mini-cellules sans un pointeur ultra-précis. La plus grosse évolution à attendre pour le tactile localisé est la détection de la présence du doigt avant le contact avec la surface (comme les travaux d’Andy Wilson cités ci-dessus). Cette évolution arrivera dans les 2 ans à venir d’après moi, Apple est déjà sur le coup avec le dépôt de son brevet # 20110007021.

Pour conclure sur ce point, en terme d’ergonomie, ce type d’interface est adapté aux périphériques mobiles (que l’on a en main ou sur ses genoux) , pas à un écran vertical (trop de fatigue musculaire en cas d’utilisation longue).

L’avenir de ce type d’IHM pour nos bons vieux postes de travail est donc ailleurs, à mon avis sur le tactile déporté : c’est-à-dire que la surface que l’on touche, caresse et tapote n’est pas l’écran. Actuellement c’est nos bons vieux trackpads qui se chargent de ça. Intégrés aux ordinateurs portables, ils colonisent maintenant nos postes de travail avec des versions de bureau. On voit même émerger des produits hybrides regroupant des fonctions de tablette graphique et trackpad (comme la gamme Bamboo Touch chez Wacom).

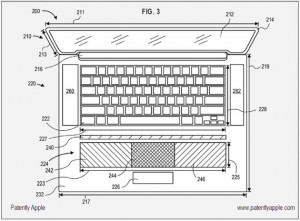

Alors, me direz-vous, si cela existe, en quoi est-ce le futur ? Et bien, vous répondrai-je, parce que la limite actuelle est que ces dispositifs permettent de contrôler un unique pointeur, on est loin du multitouch. Donc, soyons précis, l’avenir est le tactile déporté multitouch (comme le Tactapad cité ci-dessus). Et là c’est la course à l’innovation, de nouveau Apple est en course avec du dépôt de brevet dans ce domaine. L’élargissement du trackpad sur les portables est une piste sérieuse, ça laisse la place pour 2 mains. (Voir le brevet )

Qui dit nouvelle interface d’entrée (sous les doigts) dit nouvelle interface graphique (sur l’écran) pour cela les travaux du designer Robert Clayton Miller de l’agence de conception Web Tonic Blue [publication en 2009] apportent de bonnes idées. Je vous laisse découvrir cette vidéo très bien faite :

Le réel augmenté d’un sixième sens numérique

25/03/09

Pranav Mistry, assistant de recherche du Groupe des interfaces fluides du Massachusetts Institute of Technology (MIT) a encore fait sensation avec son nouveau projet présenté par sa directrice de labo Pattie Maes, lors de la conférence TED de PalmSprings en février.

Pour mémoire, Pranav Mistry était l’auteur des post-it nouvelle génération nommés « Quickies » qui ont trouvé un large écho sur le web l’an passé.

Le projet au nom de code « WUW » a été rebaptisé « Sixthsense » pour sa sortie du labo. Cette fois, l’utilisateur n’est pas dans son bureau, il est invité à bénéficier des données disponibles sur internet dans leur quotidien, et ce, sans périphérique spécifique.

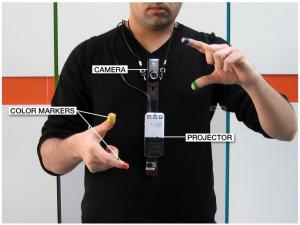

Le concept est presque simple, il allie une caméra visualisant à peu près la même chose que son porteur, un (nano) vidéoprojecteur et quatre marqueurs de quatre couleurs pour pouce et index.

La vraie innovation est de proposer une nouvelle alternative aux deux grandes façons de faire de la réalité augmentée :

• Porter des lunettes spécifiques qui sont en fait des écrans semi-transparents où sont affichées des formes ou informations. Cette (vielle) méthode ayant fâcheusement tendance à créer des maux de tête à force de demander aux yeux de faire la netteté à deux distance à la fois (le verre des lunettes très près des yeux et l’environnement plus éloigné).

• voir l’environnement réel à travers un écran qui diffuse la vidéo prise par la caméra, à laquelle s’ajoute les éléments virtuels. (Rappelez-vous du projet MARA de Nokia ou plus récemment du portage de l’API AR toolkit sur iPhone).

Cette fois, on ajoute des infos sur les objets de l’environnement eux-même ; bien sûr il faut des surfaces de projections adaptées (il vaut mieux avoir un ami avec un T-shirt blanc).

Les fonctions développées sont relativement classiques (celles que les adeptes de la réalité augmentée imaginent depuis longtemps) avec en plus des idées empruntées au monde des périphériques mobiles (avoir tous types d’informations partout tous le temps.)

Une petite vidéo vaut mieux qu’une grande description :

Plus d’informations : http://www.pranavmistry.com/projects/sixthsense/index.htm

Sisi vous le dis avec ses mains.

6/11/07

L’université d’East Anglia (royaume unis) et IBM ont communiqué en septembre dernier sur le projet qu’ils ont développé en commun. L’aboutissement de ce projet est une application qui traduit les paroles en langages des signes et qu a pour nom de code SiSi pour « Say It Sign It ».

Avatar féminin ou masculin – en démonstration vidéo ici

L’application comporte plusieurs modules mis bout a bout pour produite l’effet souhaité : Un module de reconnaissance vocale que transforme la voix en texte, un module qui transforme le texte en signes et un module qui fait effectuer ces signes à un avatar 3D. Certaines personnes commentant ce communiqué soulignent, que le visage non expressif du personnage doit affecter la compréhension.

Cette idée de traducteur virtuel automatique répond au chercheur Mexicain Jose Hernandez-Rebollar de la George Washington University. Il avait crée en 2000 un dispositif, l’ acceleglove, qui permette de traduire à travers d’un synthétiseur vocal ce qu’une personne exprimait en langage des signes.

Sources : http://www-03.ibm.com/press/us/en/pressrelease/22316.wss

Plus d’infos sur l’ acceleglove : www.seas.gwu.edu/~gogo/papers/hernandez_SIGGRAPH_2002.pdf

La Wii fait tourner la tête aux autres consoles

30/09/07

Depuis l’arrivée de la petite console blanche de Nintendo, les gyroscopes ont la cote. Nous nous souvenons de Sony qui, changeant ses plans à la dernière minute, inséra un gyro dans ses manettes de PS3.Voici une petite nouvelle, un gyroscope peux maintenant être ajouté aux PSP. Aucuns jeux « officiels » ne l’utilise, mais on imagine que les homebrews, ces sympathiques logiciels fais maison, sauront en exploiter les bienfaits.

dispo chez neoflash

Le plus gros iPhone du monde est signé Microsoft

1/06/07

Chère lecteur, pardonne ce titre pour le moins irrévérencieux qui laisse supposé qu’une fois de plus, Microsoft propose un produit incroyablement innovant qui existe déjà. Oui, Microsoft a sorti de façon officielle ce produit qui est bien plus proche de celui de Multi-Touch Interaction Research ( que je vous présentait en mars 2006 ) Que du prototype Microsoft Research présentés à Laval Virtual en 2006 (qui était un écran vertical sans contact).

Le produit lui même semble tout à fait intéressant, c’est une interface tangible de type “table” qui permet d’interagir avec différentes fonctions à l’aide de ses doigts. L’interface et ses principes d’interaction étant fortement inspirés de ce qui ce que des dizaines de laboratoires et de créatifs du monde entier proposent déjà depuis 2 ans, cela semble tout à fait réussi.

Pour une fois, aucun bouton “start” avec le logo Windows ne semble faire ingérence dans ce bel objet, enfin une innovation de la part de Microsoft.

Pour conclure ce billet engagé, je remercie Microsoft d’avoir mis la main au portefeuille, élaboré une jolie campagne de communication et envoyé Bill Gates lui montrer le bébé aux Télés, cette initiative permet de révéler ces technologies au grand public et à lancer l’industrie des périphériques tactiles grands formats, c’est le point positif.

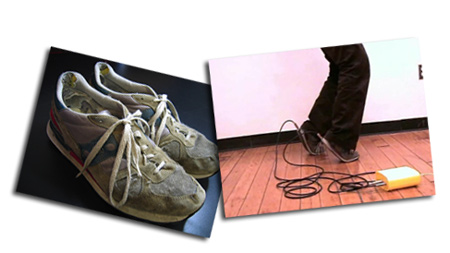

Qu’obtient-on avec 2 chaussures + 2 capteurs + une boîte de Nesquick + the king of the pop ?

13/12/06

L’école d’art numérique de new-work, l’ITP, produit de sympathiques performances artistiques. Celle que je cite ici utilise la position des pieds par rapport au sol pour ralentir une musique, en l’occurrence « I’m Bad » de l’inventeur du moon walk. Je vous propose de regarder cette vidéo afin de vous faire une idée par vous-même.

Plus d’infos

IHM nouvelle ou simple déclinaison de concept ?

12/12/06

Pour ceux et celles qui ont suivis la saga des claviers à touches OLED d’Optimus Lebdev, en voici un nouvel épisode. Après le concept de clavier « classique » ou les touches sont remplacées par des écrans OLED pour en paramétrer l’affichage (toujours en annonce de lancement pour 2007) et le Optimus mini three (maintenant en version 2) comportant seulement 3 boutons-écrans, le labo de design russe nous présente un intermédiaire intéressant (ou pas).

Ce Optimus Upravlator keyboard ressemble à un écran de 10.8″ séparé en 12 compartiments. Chacuns d’entre eux est « cliquable » sur ses quatre cotés et en son milieu. Si on compte bien ça équivaut à 5 x 12 = 60 zones cliquables pour 12 mini écrans… ça laisse de la marge pour paramétrer une sympathique interface intuitive.

Vous avez jusqu’au second semestre de 2007 pour faire fleurir les idées créatives en attendant sa sortie, et voir si cela vaux le prix qui lui sera attribuer… À suivre

plus d’info

Contrôlez l’espace sans faire de folies

29/11/06

C’est une bonne nouvelle pour le compte en banque des personne manipulant des objets virtuels 3D!

3D Connexion, la filiale de logitech spécialisé dans les périphériques de pointage et manipulation 3D vient de présenter son nouveau produit d’entrée de gamme , le SpaceNavigator Personal Edition (59eur).

Pour le terriens normaux qui ne connaissent pas le principe d’un contrôleur 3D, sachez que ce genre de périphériques est capable de manipuler un objet ou une scène 3D selon 6 degrés de liberté (alors qu’une simple souris n’en a que deux, haut-bas et droite-gauche). Là c’est 3 translation (avec la profondeur) et trois rotations qui sont captés par le périphérique. L’objet est compatible avec Sketchup et Google Earth en plus des applications pro courantes. Pour le moment, seul un driver Windows est disponible, mais le driver mac ne saurait tarder> le driver Mac est désormait disponible

Tissus réactif pour une reconnaissance des mouvements

27/11/06

Les chercheurs à la Northwestern University’s Department of Physical Medicine and Rehabilitation, ont développer un tissus capable de détecter des mouvements et donc de contrôler un fauteuils roulants.

Ce tissu rempli de capteurs est imprimé avec 52 capteurs souples, piezo-résistants fabriqués à partir de polymers électroactifs qui sont capables de changer de voltage selon l’angle vers lequel ils sont étirés. Peut être un nouveau moyen de motion capture non intrusive (avec peu d’équipement sur l’utilisateur).

Ce tissu rempli de capteurs est imprimé avec 52 capteurs souples, piezo-résistants fabriqués à partir de polymers électroactifs qui sont capables de changer de voltage selon l’angle vers lequel ils sont étirés. Peut être un nouveau moyen de motion capture non intrusive (avec peu d’équipement sur l’utilisateur).

Wiimote pour PC

27/11/06

Rien de bien extraordinaire dans cet acte, a part que cette manip permet de synchroniser la manette avec un PC. Pour le moment, le manque de driver spécifique ne permet pas d’exploiter les gyroscopes et accéléromètre de cette télécommande pas comme les autres, mais ça ne saurait tarder d’après moi.

Keep out, danger Zone !

1/06/06

Dans l’idée, ce petit gadget pour Geek est un détecteur de mauvaise position de travail. (il vous bip dessus si vous vous approchez de l’écran).

Dans l’idée, ce petit gadget pour Geek est un détecteur de mauvaise position de travail. (il vous bip dessus si vous vous approchez de l’écran).

Dans la pratique c’est un capteur de proximité pas trop cher. Domage que l’USB ne serve qu’a l’alimenter, on aurait pu l’utiliser pour de sympathiques petit jeux sinon…

Pour un détecteur de proximité plus opérationnel, allez donc voir chez Interface Z

Touche-moi que je sache qui tu es !

31/05/06

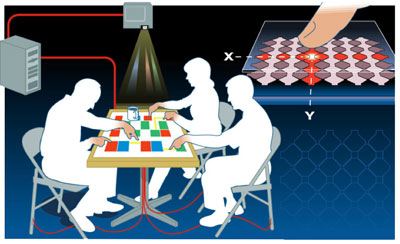

L’écran tactile, c’est bon, on connait (un doigt, un utilisateur), l’écran tactile multitouche aussi (plusieurs doigts, un utilisateur), mais comment on fait quand on est plus que un a avoir pleins de doigts ?

Une solution est proposée par les ingénieurs de MERL (Mitsubishi Electric Resarch Laboratories), et elle se nomme DiamondTouch. La technique est assez simple, chaque utilisateur est équipé d’un récepteur. Lorsqu’un doigt entre en contact avec l’écran, le signal électrique approprié circule via le corps du propriétaire jusqu’au récepteur. Un signal par personne, on sait donc qui touche où…

La Réalité Virtuelle grand public [suite]

11/05/06

Novint présente le Falcon, le périphérique 3D à retour d’effort prévu pour être commercialisé à moins de 100$.

Ce joli jouet offre un contrôl tridimensionnel en translation (3DOF en retour d’éffort comme le Phantom Omni ), pour les rotations il faudra attendre une futur version ou se rabattre sur les leaders actuels du marché de l’haptique, Sensable et Haption.

Merci à notre ami CB (dont je vous conseil le Blog) pour l’info